Mitä seuraavaksi?

Tekoälyn kehitys kiihtyy jatkuvasti ja uusia läpimurtoja odotetaan niin tutkimuksessa kuin kaupallisissa sovelluksissa. Tekoälymurros ei hidastu – päinvastoin, odotettavissa on radikaaleja harppauksia niin tutkimuksessa kuin kaupallisissa sovelluksissa.

Kuuntele samalla aiheeseen liittyvää podcastia, kun luet tekstisisältöä.

Seuraavat kehityssuunnat kattavat kokonaan uudenlaisia agentteja, multimodaalisuutta, vastuullista AI:ta ja infrastruktuurin läpimurtoja. Seuraavan pari vuotta määrittää, miten nämä läpimurrot yhdistyvät kaupallisiin tuotteisiin ja yhteiskunnallisiin ekosysteemeihin – ja kuinka vastuullisuus, turvallisuus ja kestävyys kulkevat rinnalla

Generatiivinen AI

Generatiivinen tekoäly viittaa järjestelmiin, jotka kykenevät tuottamaan uutta sisältöä – olipa kyseessä teksti, kuva, video tai musiikki – autonomisesti tai osin ihmisen ohjauksessa. Tällaiset mallit, kuten suurikokoiset kielimallit tai difuusiopohjaiset kuvageneraattorit, rakentavat uuden sisällön tilastollisista riippuvuuksista valtavissa datakorpuksissa. Tämän kehityksen myötä muutos sisällöntuotannon paradigmassa on merkittävä: luovan työn rajat siirtyvät, ja ihmisen rooli siirtyy ideoinnista yhä enemmän kuratoinnin ja ohjaamisen suuntaan. Samalla syntyy uusia haasteita liittyen tekijänoikeuksiin, alkuperän tunnistamiseen ja luovan aitouden käsitteeseen.

Mitä generatiivinen AI on käytännössä?

Mitä generatiivinen tekoäly on?

Generatiivinen tekoäly tarkoittaa järjestelmiä, jotka tuottavat uutta sisältöä – tekstiä, kuvia, videoita tai musiikkia – oppimalla tilastollisia riippuvuuksia massiivisista datakorpuksista. Tällaiset mallit, kuten suurikokoiset kielimallit (GPT-4, Claude, Gemini) ja difuusiopohjaiset kuvageneraattorit (DALL·E 3, Stable Diffusion, MidJourney), kykenevät luomaan koherenttia ja usein luovaa sisältöä joko täysin itsenäisesti tai ihmisen ohjauksessa.

Nykyiset mahdollisuudet

- Tekstisisällöntuotanto

- Chatbotit ja automaattiset sisällöntuotantotyökalut tuottavat artikkeleita, yhteenvetoja ja analyysiä sekunneissa.

- Yritykset integroivat kielimalleja asiakaspalveluun, markkinointikampanjoihin ja sisäisiin raportteihin [8].

- Kuvien ja videoiden generointi

- Kuvageneraattorit luovat prompteista korkearesoluutioisia kuvia ja yksityiskohtaisia taideteoksia.

- Ensimmäiset generatiiviset videotyökalut syntetisoivat lyhyitä animaatioita tekstikuvauksesta [7].

- Musiikin ja äänen tuottaminen

- Mallit, kuten Jukebox ja MusicLM, tuottavat alkuperäisiä kappaleita eri genreissä.

- Äänikloonaus ja puhesynteesi mahdollistavat realistiset puhesisällöt ilman ääninäyttelijöitä.

- Dataaugmentaatio ja simulaatiot

- Syntetisoidulla datalla täydennetään puutteellisia koulutusjoukkoja koneoppimismalleissa.

- Simulaatiopohjaiset ympäristöt, joissa generatiiviset mallit tuottavat realistisia skenaarioita koulutukseen ja testaamiseen.

- Tieteellinen ja kaupallinen innovaatio

- AlphaFold-niminen malli mullisti proteiinien rakenteiden ennustamisen, kiihdyttäen lääketutkimusta ja materiaalitutkimusta [15].

- Generatiivinen AI otetaan käyttöön lääketieteessä, rahoituksessa ja koulutuksessa, missä se tuottaa asiakaskohtaisia hoitosuunnitelmia, riskianalyysejä ja oppimateriaaleja [8].

Tulevaisuuden suuntaukset

- Hyperpersonalisointi

Jokainen asiakas saa reaaliaikaista, yksilöllistä sisältöä – mainokset, artikkelit, videoleikkeet ja kurssimateriaalit räätälöityinä maksimivaikuttavuuteen [15]. - Agenttimuotoiset työkaluketjut

Generatiiviset agentit hoitavat monitahoisia tehtäviä: ne suunnittelevat, toteuttavat ja dokumentoivat prosesseja itsenäisesti, koordinoiden tarvittaessa eri API-rajapintoja ja datastrategioita [7]. - Monimodaalinen ja interaktiivinen media

- Yhteen sulautuvat teksti-, ääni-, kuva- ja videosisältö luovat immersiivisiä kokemuksia, kuten virtuaalitodellisuusmaisia oppimisympäristöjä tai räätälöityjä markkinointikokemuksia.

- ControlNetin kaltaiset ohjauskehykset varmistavat sisällön loogisen ja kontekstuaalisen yhtenäisyyden eri formaattien välillä [7].

- Domain-spesifinen hienosäätö reunalaitteissa

Reunalla (edge) suoritettavat pienennetyt generatiiviset mallit mahdollistavat offline-tilassa reaaliaikaisen sisällöntuotannon ja suojatun datankäsittelyn esimerkiksi itsenäisissä dronessa tai lääketieteellisissä diagnostilaitteissa. - Luotettavuus, aitous ja jäljitettävyys

- Vedenmerkintä ja kryptografinen signaus varmistavat generoidun sisällön alkuperän.

- Explainability-menetelmät havainnollistavat, miten malli on päätynyt tiettyyn lopputulokseen.

- Eettinen ja sääntely-kehys

- Yhtenäiset standardit ja sertifikaatit varmistavat, ettei generatiivista AI:ta käytetä väärin valeuutisten tai deepfake-hyökkäysten levittämiseen.

- EU:n AI-säädös asettaa selkeät rajat mallien kehitykselle, testaamiselle ja käyttöönotolle.

Keskeiset hyödyt ja haasteet tulevaisuudessa

| Aspect | Mahdollisuudet | Haasteet |

|---|---|---|

| Innovaatio | Räätälöidyt, interaktiiviset ja agentinomaiset työkaluketjut | Mallien hallinta, esitysmittareiden standardointi |

| Skaalautuvuus | Joustava integraatio pilvi-edge-ympäristöissä | Laskentatehon ja energiatehokkuuden balansointi |

| Turvallisuus | Data pysyy laitteessa, nollaluottamusarkkitehtuurit | Hyökkäysvektoreiden monimuotoisuus, mallien väärinkäyttö |

| Regulointi ja eettisyys | Läpinäkyvät auditointimekanismit | Riippuvuus lainsäädännön hitaasta reagoinnista |

Generatiivinen AI on murroksessa. Nykyiset työkalut tuottavat jo laadukasta sisältöä ja tehostavat liiketoimintaprosesseja, kun taas tulevaisuuden agenttiketjut, monimodaalisuus ja hyperpersonalisointi siirtävät luovan työn rajoja entisestään. Samalla on huolehdittava eettisistä periaatteista, sääntelystä ja luotettavuudesta, jotta teknologian positiivinen potentiaali voidaan maksimoida yhteiskunnan hyödyksi.

Reunatiedon tekoäly (Edge AI)

Reunatiedon tekoäly tarkoittaa laskennallisen kapasiteetin siirtämistä lähemmäksi datan syntypaikkaa – esimerkiksi antureihin, mobiililaitteisiin tai teollisiin koneisiin. Tämä kehityssuunta haastaa keskitetyn pilvilaskennan hallitsevan aseman ja mahdollistaa reaaliaikaisen päätöksenteon sekä vähentää latenssia ja energiankulutusta. Turvallisuus paranee, kun sensitiivistä tietoa ei tarvitse siirtää pilveen, ja infrastruktuurin riippuvuus keskitetystä palvelusta vähenee. Reuna-AI avaa myös uusia mahdollisuuksia syrjäseutujen teknologiselle omavaraisuudelle ja datasuvereniteetille.

Mitä reunatiedon tekoäly on käytännössä?

Mikä on Edge AI nyt?

Reunatiedon tekoäly tarkoittaa koneoppimismallien ja inferenssin suorittamista lähellä datan syntypaikkaa antureissa, mobiililaitteissa tai teollisissa laitteissa sen sijaan, että raaka data lähetettäisiin ensin keskitettyyn pilvipalveluun. Tämä lähestymistapa minimoi viiveen, vähentää verkon kuormitusta ja parantaa yksityisyyden suojaa, kun sensitiivistä dataa ei tarvitse siirtää verkon yli keskuspalvelimelle.

Edge AI käytännössä nykytilassa

- Sensoriaineiston prosessointi suoraan reunalaitteissa, joissa reaaliaikaiset inferoinnit toteutetaan paikallisilla mikropalvelimilla tai erikoispiireillä (TPU, NPU).

- Tuotantolaitosten ennakoiva huolto, jossa laitteiden sensoridataa analysoidaan konenäkö- ja aikasarjamalleilla laadunpoikkeamien ja vikaantumisen ennakointiin ilman pilviyhteyttä.

- Älykkäät sähköverkot, joissa reunalaitteet optimoivat energianjakelua ja kuormanhallintaa paikallisilla mittaustiedoilla parantaen verkon joustavuutta ja luotettavuutta.

- Terveydenhuollon kannettavat laitteet, jotka seuraavat potilaan elintoimintoja ja havaitsevat poikkeavuudet offline-tilassa ilman jatkuvaa yhteyttä pilveen.

Haasteet ja rajoitteet nyt

- Rajoitettu laskentateho ja energiankulutus edge-laitteissa asettavat paineita mallien kevyyteen ja optimointiin käytännössä, kun laitteissa on vaatimaton CPU/GPU-resurssitarjonta.

- Laite- ja järjestelmäekosysteemien heterogeenisyys vaikeuttaa yhtenäisten kehitys- ja päivitysprosessien rakentamista eri laitevalmistajien reuna-alustoille.

- Hajautetun datankäsittelyn tietoturva- ja yksityisyyskysymykset korostuvat, kun kriittistä dataa liikkuu monen toimijan laitteiden välillä ilman keskitettyä valvontaa.

- Mallien elinkaaren hallinta on haastavaa, kun reunalaitteet voivat olla pitkäaikaisesti offline-tilassa tai kaistarajoitetuissa verkoissa, mikä vaikeuttaa jatkuvaa päivitystä ja monitorointia.

Tulevaisuuden suuntaukset

Reunatiedon tekoäly kehittyy tulevina vuosina hajautetummaksi, autonomisemmaksi ja tiiviimmin yritysten ja laitevalmistajien ekosysteemeihin integroiduksi.

- Agentic Edge AI

Laitteet ja reunapalvelimet tekevät itsenäisiä päätöksiä ja toimenpiteitä ihmisen minimiohjauksella, mikä tehostaa automaattista vikakorjausta, liikenteenohjausta ja turvallisuustoimenpiteitä reaaliajassa. - Generatiivinen tekoäly reunalla

Suurten kielimallien ja generatiivisten mallien (esim. LLM) inferenssiä ajetaan paikallisesti reunalaitteissa, mahdollistaen offline-tilassa tapahtuvan sisällöntuotannon, kääntämisen ja analytiikan ilman pilviyhteyttä. - Reunapalvelualustat (Edge AI Platforms)

Yritykset siirtyvät proof-of-concept -vaiheesta kohti täysimittaista infrastruktuurin käyttöönottoa, ja ECP:t toimivat reunalaitteiden hallinnan, orkestroinnin ja skaalauksen selkärankana. - Nollaluottamus-arkkitehtuuri

Reuna-ympäristöjen tietoturva perustuu jatkuvaan todennukseen, salaukseen ja granulaariseen pääsynhallintaan estäen luvattoman pääsyn hajautetussa verkossa. - Hybridireuna-pilvi-ydin-integraatio

Työnkulut ja inferoinnit jaetaan dynaamisesti laitteen, paikallisverkon ja pilven välillä, minkä ansiosta saavutetaan matala latenssi sekä kustannustehokas skaalautuvuus. - Toimialakohtaiset modulaariset paketit

Alaspesifiset reunamoduulit ja rajapinnat terveydenhuollolle, valmistavalle teollisuudelle ja älykaupunkiratkaisuille nopeuttavat käyttöönottoa ja varmistavat vaatimustenmukaisuuden. - Standardoidut ekosysteemit ja markkinapaikat

Yhtenäiset protokollat ja markkinapaikat, joissa laitevalmistajat, ohjelmistokehittäjät ja järjestelmäintegraattorit jakavat ja ostavat valmiita reunatiedon AI ‑komponentteja, lisäävät innovaatiota ja kiihdyttävät käyttöönottoa.

Reunatiedon tekoäly tulee laajentamaan sovellusalueitaan, kun hajautetun laskennan teho kasvaa, ekosysteemit vakiintuvat ja turvallisuusratkaisut kypsyvät. Samalla se mahdollistaa reaaliaikaisen automaation ja älykkäät päätökset siellä, missä data syntyy.

Yhdistettävä AI (Composable AI)

Yhdistettävän tekoälyn ytimessä on modulaarisuus: sen sijaan että kehitetään monoliittisia järjestelmiä, voidaan rakentaa skaalautuvia arkkitehtuureja yhdistämällä erilaisia esikoulutettuja komponentteja, kuten NLP-moduuleja, konenäön algoritmeja ja päätöksentekologiikkoja. Tämä mahdollistaa organisaatioille ketterämmän kehitysprosessin, jossa AI-ratkaisuja voidaan konfiguroida, muokata ja päivittää jatkuvasti vastaamaan muuttuvia tarpeita. Paradigma muistuttaa ohjelmistokehityksen mikropalveluarkkitehtuuria ja edistää tekoälyn demokratisoitumista.

Mitä yhdistettävä AI on käytännössä?

Mikä on yhdistettävä AI?

Yhdistettävä AI perustuu modulaariseen arkkitehtuuriin: sen sijaan että rakennettaisiin yksi massiivinen “kaikki yhdessä” -malli, tekoälyjärjestelmä koostetaan vaihtokelpoisista, itsenäisistä komponenteista. Kukin komponentti on erikoistunut tiettyyn tehtävään (esim. luonnollisen kielen käsittely, kuvantunnistus, päätöksenteko) ja kommunikoivat toistensa kanssa selkeiden rajapintojen kautta. Tämä lähestymistapa muistuttaa mikropalveluarkkitehtuuria, mutta sovellettuna tekoälyyn.

Keskeiset komponentit ja arkkitehtuuri käytännössä

| Komponentti | Toiminto | Esimerkkejä |

|---|---|---|

| NLP-moduuli | Tekstin ymmärrys ja generointi | Hugging Face Transformers, OpenAI |

| Konenäkömoduuli | Kuvien luokittelu, objektin segmentointi | YOLO, Detectron2 |

| Orkestraattori | Moduulien koordinointi ja työnkulkujen hallinta | LangChain, Apache Airflow |

| Data Layer | Datan varastointi, indeksointi ja haku | Snowflake, Databricks, Pinecone |

| Päätöksentekologikka | Liikerule-, reegli- tai vahvistusoppimispohjainen päätösten teko | Custom Rules, reinforcement learning |

| Monitorointi & Governance | Suorituskyvyn seuranta, auditointi, malliversiohallinta | MLflow, Seldon, Prometheus |

Käytännön esimerkit nyt

- Monikanavainen asiakaspalvelu

Chatbot ohjaa käyttäjän kysymyksen NLP-moduulille, joka tarvittaessa hakee taustatiedot vector-tietokannasta. Lopuksi päätöksentekologiikka muotoilee vastauksen ja monitorointi kerää metriikat. - Älykäs laadunvalvonta

Reaaliaikaiset kameravyöhykkeet syöttävät kuvat konenäkömoduulille, joka tunnistaa poikkeamat. Poikkeukset raportoidaan ERP-järjestelmään ja inhimillinen tarkistus tehdään automaattisesti, jos todennäköisyys epäonnistumiselle ylittää määritellyn kynnyksen. - Rahoitusprosessien automaatio

Skannatut kuitit OCR-moduuliin, josta puhdistettu teksti jatkaa NLP:n kautta sisällön tarkistukseen. Fraud-moduuli arvioi riskin ja päätöksentekoyksikkö hyväksyy tai hylkää maksun.

Mitä haasteita on ratkaistava

- Rajapintojen standardointi

Erilaisten toimittajien moduulit tarvitsevat yhteiset protokollat (esim. OpenAPI, gRPC), jotta uusien komponenttien lisäys tai vaihto onnistuu nopeasti. - Tietoturva ja yksityisyys

Data liikkuu erilaisten pisteiden välillä. Salauksen, pääsynhallinnan ja auditoinnin on katettava koko ketju ilman heikennystä. - Orkestroinnin kompleksisuus

Kun agenteilla on erilaisia versioita ja riippuvuuksia, monimutkaisuus kasvaa. Skaalautuvat työkalut (Kubernetes, Airflow, LangGraph) ovat välttämättömiä.

Tulevaisuuden suuntaukset

- Teollisuusspesifiset markkinapaikat

Sertifioidut moduulit eri toimialoille (terveydenhuolto, fintech, manufaktuuri) nopeuttavat käyttöönottoa ja varmistavat laatutason. - Älykäs komponenttien löytäminen ja rekisteröinti

Dynaamiset “AI-arkistot”, jotka ehdottavat ja testaavat optimaalista yhdistelmää saatavilla olevista moduuleista. - Monimodaaliset agenttiketjut

Itseohjautuvat agentit, jotka yhdistävät teksti-, ääni-, kuva- ja sensoridataa saumattomasti, automaattisesti valiten oikean moduulin kuhunkin osatehtävään. - Edge + Cloud -yhdistäminen

Resurssien jakaminen äärilaitteiden ja pilvipalveluiden välillä vähentää latenssia ja optimoi kustannukset. - Governance-as-a-Service

Modulaariset valvonta-, auditointi- ja selitettävyyskomponentit liitetään automaattisesti kuhunkin uuteen AI-ketjuun.

Näin yhdistettävän AI rakentaminen etenee

- Investoi orkestrointialustoihin, kuten Kubeflow Pipelines, LangGraph tai Airflow, joilla monivaiheiset työnkulut saa hallintaan.

- Rakenna sisäinen moduulikirjasto pienistä, uudelleenkäytettävistä komponenteista (datapreprocessing, validointi, testaus).

- Kouluta tiimit mikropalvelu- ja DevOps-periaatteisiin, jotka tukevat modulaarista kehitystä ja jatkuvaa toimitusta.

- Aloita proof-of-concept -hankkeilla, joissa hyödynnetään pelkästään avoimia, kolmannen osapuolen API-moduuleja ja arvioi niiden integrointi nykyisiin järjestelmiin.

Yhdistettävä AI ei ole vain teknologiatrendikkyyttä vaan tapa luoda ketterämpiä, kustannustehokkaampia ja helposti ylläpidettäviä tekoälyjärjestelmiä. Modulariteetti vapauttaa tiimit keskittymään liiketoimintalogiikkaan, kun alustan tekniset yksityiskohdat ovat hallittuna valmiina palasina.

Tekoälyn sääntely

Tekoälyn sääntely nousee kriittiseksi vastapainoksi teknologian nopealle kehitykselle. Sääntelyinstrumenttien – kuten EU:n AI Act – tavoitteena ei ole ainoastaan riskien minimointi, vaan tekoälyn ohjaaminen kohti yhteiskunnallisesti hyväksyttäviä päämääriä. Sääntelyssä korostuvat eettiset periaatteet, kuten oikeudenmukaisuus, läpinäkyvyys ja ihmiskeskeisyys. Lisäksi sääntelyä tarvitaan vastuiden määrittelyyn tilanteissa, joissa tekoäly tekee päätöksiä ihmisen puolesta. Kysymys kuuluu: kuka kantaa vastuun, kun algoritmi epäonnistuu?

Mitä tekoälyn sääntely on käytännössä?

Sääntelyn merkitys nykytilassa

Tekoälyn sääntelyllä pyritään tasapainottamaan innovaatiot ja riskienhallinta siten, että teknologia palvelee yhteiskuntaa eettisesti ja vastuullisesti. Sääntelyn tavoitteina ovat perusoikeuksien turvaaminen, algoritmien läpinäkyvyys ja ihmiskeskeisyys sekä selkeiden vastuuketjujen luominen tilanteisiin, joissa tekoälyjärjestelmät tekevät päätöksiä ihmisen puolesta.

Keskeiset kansainväliset sääntelykehykset nyt

| Maantieteellinen alue | Sääntelykehys | Tunnuspiirteet |

|---|---|---|

| Euroopan unioni | AI Act | Riskipohjainen luokittelu: kielletyt, korkean riskin ja vähäriskiset järjestelmät; vaatimukset dokumentaatiolle, läpinäkyvyydelle ja kolmannen osapuolen tarkastuksille. |

| Yhdysvallat | Toimialakohtainen lähestymistapa; Bidenin toimeenpanomääräykset | Ministeriökohtaiset ohjeistukset, NISTin riskienhallintakehys, FTC:n tutkinnat ja vapaaehtoiset standardit; liittovaltiotason lainsäädäntö puuttuu vielä kokonaisuudessaan. |

| Kiina | Interim Measures for the Management of Generative AI Services | Generatiivisten palveluiden rekisteröinti, sisällön jäljitettävyys ja valtion valvonta; reaalinimijärjestelmä ja sensuurivaatimukset paikallisten määräysten mukaisesti. |

| Yhdistynyt kuningaskunta | Pro-innovation white paper; sektorikohtaiset sääntelyelimet | Toimintaperusteinen lähestymistapa ilman yhtenäistä lakia; Financial Conduct Authorityn kuluttajavelvoitteet ja AI Safety Summit -aloitteet. |

| Kanada | Proposed Artificial Intelligence and Data Act (AIDA) sekä vapaaehtoiset eettiset ohjeet | Hallinnolliset vaatimukset riskien arvioinnille, läpinäkyvyydelle ja ihmiskeskeiselle valvonnalle; lainsäädännön kohtalo epävarma vaalien vuoksi. |

| Muut alueet | Singapore Model AI Governance Framework; Australian Voluntary AI Safety Standard; Afrikan kansalliset strategiat | Parhaat käytännöt, vapaaehtoiset guardrailit ja kansalliset AI-strategiat korostavat alueellista sovellettavuutta ja toimintavapauden sekä turvallisuuden tasapainoa. |

Maailmanlaajuisesti ainakin 69 maata on ehdottanut yli 1000 tekoälyyn liittyvää politiikka-aloitetta tai säädöstä, mikä korostaa sääntely-ympäristön laajuutta ja fragmentoitumista.

Sääntelyn käytännön toteutus

- Riskiluokittelu ja sertifiointi

Järjestelmät arvioidaan riskitason perusteella. EU:ssa korkean riskin sovellukset tarvitsevat kolmannen osapuolen tarkastuksen ja jatkuvan auditoinnin; vähäriskiset voivat noudattaa yksinkertaisempia vaatimuksia. - Algoritminen vaikutustenarviointi

Yritykset toteuttavat AI Impact Assessment -menettelyt, joissa selvitetään mahdolliset syrjivät vaikutukset, yksityisyysriskit ja turvallisuuskysymykset ennen tuotantoon viemistä. - Dokumentaatio ja läpinäkyvyys

Mallin koulutusdata, päätöslogiikka ja toimintaympäristö dokumentoidaan standardisoidusti. EU vaatii selkeät käyttöohjeet ja jäljitettävyysketjut mallin kehitykselle ja päivityksille. - Vastuuketjut ja lakisääteinen vastuu

AI Liability Directive -ehdotus EU:ssa pyrkii modernisoimaan siviilioikeudellista vastuuta, kun tekoälyjärjestelmä aiheuttaa vahinkoa, ja selkeyttämään, kuka kantaa korvausvelvollisuuden. - Standardit ja sertifikaatit

Kansainväliset ISO- ja IEEE-standardeihin pohjautuvat sertifioinnit sekä vapaaehtoiset etikettijärjestelmät (AI Ethics Labeling) edistävät yhteistä ymmärrystä vastuullisesta AI:n kehityksestä.

Tulevaisuuden sääntelytrendit

- Globaalin yhdenmukaistamisen vahvistuminen

EU AI Actin mallia seuraavat useat maat, ja OECD:n periaatteista muodostuu pohja yhteisille sääntelyverkostoille, jotka helpottavat kansainvälistä teknologiavaihtoa ja kilpailua. - Reaaliaikainen seuranta ja valvonta

Pilvipohjaiset Compliance-as-a-Service -ratkaisut linkittävät AI-järjestelmiin sisäänrakennetun auditoinnin, joka raportoi automaattisesti poikkeamat sääntelyvaatimuksista. - Sääntelynsandbokseissa kehittäminen

Monimutkaisten ja kriittisten AI-sovellusten testaamista sääntely-ympäristöissä eli sandbokseissa laajennetaan, jotta innovaatiot voidaan validoida hallitusti ennen laajamittaista käyttöönottoa. - Vastuullisuus-by-Design ja AI Passport

Jokainen AI-järjestelmä saa digitaalisen “passin”, joka sisältää tiedot sen kehitysprosessista, vastuuhenkilöistä, turvallisuustesteistä ja eettisistä arvioinneista. - Dynaaminen sääntelymalli ja adaptiiviset ohjeistukset

Sääntely kehittyy nopeiden teknologiamurrosten mukaan, ja viranomaiset hyödyntävät tekoälyä itse sääntöjen simulointiin ja vaikutusten ennakointiin. - Laajentuvat vastuuketjut ja vakuutusmekanismit

Yritykset solmivat tekoälyvakuutuksia ja teknologiajätit rakentavat kompensaatiorahastoja, joilla korvataan AI:n aiheuttamia inhimillisiä tai taloudellisia vahinkoja.

Yhteenveto

Tekoälyn sääntely on monitasoinen kokonaisuus, jossa lainsäädännölliset kehykset, vapaaehtoiset standardit ja tekniset auditointimenetelmät muodostavat toisiaan täydentävän ekosysteemin. Nykyisellään EU on säätelyn kärjessä riskipohjaisuudellaan, kun taas Yhdysvallat luottaa sektoriaiheutuneisiin suosituksiin. Tulevaisuudessa globalisoitu, adaptiivinen ja automatisoitu sääntely mahdollistaa AI-innovaatioiden laajemman hyväksynnän ja vastuullisen käytön.

Itseohjautuva oppiminen

Perinteiset valvotun oppimisen menetelmät ovat datariippuvaisia ja edellyttävät merkittävää ihmistyötä luokittelun tai annotoinnin muodossa. Itseohjautuva oppiminen, joka hyödyntää mm. self-supervised learning -periaatteita, pyrkii vähentämään tätä riippuvuutta ja mahdollistamaan mallien oppimisen osittain jäsentelemättömästä datasta. Tämä kehityssuunta on lupaava erityisesti aloilla, joilla laadukasta opetusdataa on vaikea tuottaa tai kerätä. Samalla se haastaa perinteiset arviointikäytännöt ja tuo esiin uudenlaisia mallien tulkinnallisuuden haasteita.

Mitä itseohjautuva oppiminen on käytännössä?

Mikä on itseohjautuva oppiminen

Itseohjautuva oppiminen (self-supervised learning) on koneoppimisen paradigma, jossa mallit oppivat jäsentelemättömästä datasta luomalla itselleen valvontasarjoja ilman ihmisen tekemiä merkintöjä. Tämä vähentää riippuvuutta kalliista, manuaalisesti luokitellusta opetusdatasta ja mahdollistaa oppimisen isoilla, ei-merkitytetyillä aineistoilla.

Keskeiset menetelmät nyt

Itseohjautuvassa oppimisessa yleisimpiä tekniikoita ovat:

- Contrastive learning

Mallit, kuten SimCLR ja MoCo, oppivat erottamaan saman datan eri augmentaatioita (positiivisia pareja) muusta datasta (negatiivisia pareja), mikä tuottaa semanttisesti rikkaat edustukset. - Masked Image Modeling (MIM)

Kuvat pilkotaan pieniin osiin, osa peitetään ja malli oppii ennustamaan puuttuvat pikselit takaisin, mikä kehittää syvällistä visuaalista ymmärrystä. - Klusterointipohjaiset menetelmät

Menetelmät kuten DINO ja Caronin ryhmittelyrakenteet käyttävät pseudo-luokkia (klustereita) opetusmerkintöjen korvikkeina, jolloin malli löytää datasta luonnollisia ryhmiä ilman manuaalista etikettityötä.

Nämä lähestymistavat ovat tuottaneet huomattavia parannuksia edustusten laatuun ja klusterointiominaisuuksiin ilman valvottua oppimista.

Uudet menetelmät: Representation Self-Assignment (ReSA)

Viimeisin innovaatio on ReSA (Representation Self-Assignment), joka hyödyntää mallin omia klusterointiominaisuuksia positiivisen palautteen kautta. ReSA havaitsi, että itseohjautuvien mallien enkooderien tuottamat edustukset klusteroituvat luontevasti ja hyödyntämällä tätä voi vahvistaa oppimista entisestään. Tuloksena on aiempia SSL-menetelmiä selvästi parempi klusterointisuoritus sekä hienorakeinen että karkeampi semanttinen rakenne.

Sovellukset ja haasteet

Itseohjautuvaa oppimista hyödynnetään jo laajalti:

- Visio-mallit

Vision Transformer ‑arkkitehtuurit, jotka on esikoulutettu SSL-menetelmillä, päihittävät perinteiset CNN-pohjaiset mallit luokitus-, segmentointi- ja tunnistustehtävissä vähällä merkitsemällä datalla. - Luonnollinen kieli

Masked Language Modeling ‑tekniikoiden (BERT, GPT) kautta mallit oppivat kielen rakenteen ennustamalla sanoja kontekstin perusteella, mikä parantaa suoraan käännös- ja ymmärrystehtävien laatua.

Arvioinnin ja tulkittavuuden haasteet vaativat uusia mittareita, koska perinteiset tarkkuus- ja manuaalinen validointi eivät riitä automaattisesti syntetisoitujen pretekstitehtävien arviointiin.

AI-palveluna (AI-as-a-Service)

Tekoälyratkaisujen tarjoaminen palveluna edustaa liiketoimintamallin muutosta, jossa algoritmit ja mallit eivät enää vaadi suuria sisäisiä investointeja, vaan voidaan integroida osaksi sovelluksia API-rajapintojen kautta. Tämä madaltaa merkittävästi AI:n käyttöönoton kynnystä erityisesti pienissä ja keskisuurissa yrityksissä. Se mahdollistaa kokeilukulttuurin, jossa uusia ideoita voidaan testata nopealla syklillä, ja edistää datavetoinen innovaatiota skaalautuvilla alustoilla.

Mitä AI-as-a-Service palveluita on tarjolla?

AI-as-a-Service tarkoittaa tekoälykyvykkyyksien tarjoamista pilvipohjaisen tilausmallin kautta siten, että yrityksen ei tarvitse investoida kalliiseen laitteistoon, asiantuntijatiimiin tai pitkäaikaisiin kehitysprojekteihin. Palveluntarjoaja huolehtii infrastruktuurista, mallien koulutuksesta ja päivityksistä, ja asiakas maksaa pääosin käytön mukaan. Tämä madaltaa erityisesti pienten ja keskisuurten yritysten kynnystä kokeilla uusia AI-ideoita ketterästi ja skaalautuvasti.

Nykyiset AI-as-a-Service -palvelut

| Palvelutyyppi | Esimerkkejä | Käyttötarkoitus |

|---|---|---|

| NLP ja käännöspalvelut | Azure Cognitive Services, AWS Comprehend, Google NLP | Tekstianalyysi ja monikielinen käännös |

| Puhe- ja puheentunnistus | AWS Transcribe, Google Speech-to-Text | Äänikomentojen käsittely ja analyysi |

| No-code/low-code AI-kehitysympäristöt | Debut Infotech AI Studio, Azure AI Studio | Chatbotit, prototyyppien rakentaminen |

| Koneoppimisen hallintapalvelut | AWS SageMaker, Azure Machine Learning, Google Vertex AI | Mallien koulutus, devops ja optimointi |

| Agentit palveluna (AaaS) | Zyter Symphony, Aquant Agentic AI, Epiq Service Cloud | Moniagenttinen orkestrointi ja automaatio |

Lähteet: Forbes, Debut Infotech, Zyter Symphony, Aquant, Epiq

Tulevaisuuden AI-as-a-Service -suuntaukset

- Industry-specific AI-mallit räätälöitynä palveluna

Palveluntarjoajat kehittävät valmiita malleja eri toimialojen tarpeisiin, kuten terveydenhuoltoon, finanssiin ja logistiikkaan. Tällaiset mallit lyhentävät käyttöönottoaikaa ja parantavat tarkkuutta kontekstisidonnaisissa tehtävissä. - Edge AI integroituna pilveen

Älykkäät reunalaitteet suorittavat reaaliaikaista analytiikkaa ilman jatkuvaa yhteyttä keskuspilveen, mutta skaalautuvat pilvipalvelun kautta tarpeen mukaan. Tämä vähentää latenssia ja parantaa tietoturvaa arkaluonteisissa ympäristöissä. - Low-code ja no-code -ympäristöjen laajentuminen

Visuaaliset työkalu- ja työpöytäympäristöt madaltavat AI-kehityksen kynnystä entisestään, jolloin liiketoimintayksiköt voivat rakentaa ja kouluttaa malleja ilman syvää teknistä osaamista. - Explainable AI ja eettiset viitekehykset

Palveluihin lisätään läpinäkyvyyttä ja vastuullisuutta tukevia moduuleja, jotka selittävät mallien päätökset ja auttavat noudattamaan tietosuoja- ja eettisiä vaatimuksia, erityisesti terveydenhuollossa ja rahoitusalalla. - Hyper-personalisointi reaaliaikaisilla oivalluksilla

AI-palvelut hyödyntävät käyttäjädatan analytiikkaa räätälöityjen suositusmoottoreiden, dynaamisten käyttöliittymien ja monikanavaisen personoinnin toteuttamiseksi jopa millisekunneissa. - Agentit ja orkestroitu automaatio

Agentic AI -alustat tuovat markkinoille palveluna modulaarisia, itseoppivia agentteja, jotka koordinoivat liiketoimintaprosesseja holistisesti ja oppivat käyttäjän palautteesta jatkuvasti (esim. modulaariset Agent-as-a-Service-ratkaisut).

Kvanttitietokoneiden yhdistäminen

Kvanttilaskennan yhdistäminen klassiseen tekoälyyn avaa teoreettisesti uusia horisontteja laskennallisesti raskaiden ongelmien ratkaisemiseen, erityisesti sellaisilla osa-alueilla kuin optimointi, kompleksiset simulaatiot ja kryptografia. Hybridilaskennan mallissa kvanttitietokoneet voisivat käsitellä tiettyjä alitehtäviä, jotka ovat klassisille järjestelmille vaikeasti hallittavissa. Tämä edellyttää kuitenkin uudenlaista arkkitehtuuriajattelua ja yhteensopivuutta nykyisten AI-kehitysalustojen kanssa.

Kuulostaa vielä aika Scifi:ltä?

Kvanttitietokoneiden ja klassisen tekoälyn hybridilaskenta

1. Mikä on hybridilaskenta kvantti-AI:ssa?

Hybridilaskentamalli jakaa monimutkaisen tehtävän klassisiin ja kvanttilaskentaan sopiviin alitehtäviin. Klassinen osuus hoitaa datan esikäsittelyn ja iteratiiviset optimointisilmukat, kun taas kvanttitietokone (QPU) suorittaa kvanttipiireihin perustuvia aligoritmeja (esim. VQE, QAOA), joissa superpositio ja lomittuminen antavat eksponenttisen etulyöntiaseman tietyissä ongelmissa.

2. Nykytila

2.1 Kvanttilaitteet käytettävissä nyt

- Pilvipohjaiset kvanttipalvelut

IBM Quantum Experience, Google Quantum AI, Amazon Braket (IonQ, Rigetti) ja Microsoft Azure Quantum mahdollistavat etäkäytön reaalimaailman kvanttikoneille ilman omaa laitteistoa. - Suurimmat prototyypit

IBM:n 1000+ kubitin “Condor”-prosessori on toistaiseksi pisimmällä skaalauksessa.

IQM:n 54-kubitin täyspin-supraconducting-järjestelmä integroituu pian yhteen maailman nopeimmista supertietokoneista Bolognassa.

2.2 Hybridialgoritmit ja kehykset

- Variational Quantum Eigensolver (VQE) ja Quantum Approximate Optimization Algorithm (QAOA) ovat ensimmäisiä kaupallisesti hyödynnettyjä hybridiratkaisuja, joissa klassinen optimointilooppi säätää kvanttipiirin parametreja.

- Kehyskirjastot kuten PennyLane, Qiskit Runtime ja TensorFlow Quantum tarjoavat abstrahoidun rajapinnan, jolla AI-mallit voivat kutsua kvanttilaskentaa osana suurempaa koneoppimisputkea.

2.3 Käytännön sovellukset

| Sovellusalue | Klassinen osuus | Kvanttialitehtävä |

|---|---|---|

| Optimointi | Gradienttipohjaiset menetelmät | QAOA-pohjaiset ratkaisuhakut |

| Molekyylisimulaatiot | Newton-dynamikka, Monte Carlo | VQE ja kvanttisimulaatiot tarkkojen energiatilojen löytämiseksi |

| Kryptografia ja turvallisuus | Salauksen hallinta | Kvanttivarmenteet (QKD), kvantti-avaruusanalyysi |

3. Kvanttikoneiden ohjelmointi

3.1 Keskitetyt kvanttikielet ja SDK:t

- Qiskit (Python): IBM:n ekosysteemin lippulaiva, jota käytetään laajalti kvanttipiirien rakentamiseen ja suorittamiseen pilvessä.

- Cirq (Python): Googlen avoimen lähdekoodin kirjasto, optimoitu Sycamore-arkkitehtuurille.

- Q# (Microsoft): Haskell-tyylinen kieli, integroituu .NET-ja Azure-ekosysteemeihin.

Näiden lisäksi nousevia kieliä ovat Silq ja OpenQASM, sekä korkeamman tason kehykset kuten PennyLane, jotka tuovat kvanttilaskennan osaksi tuttua AI-workflow’ta.

3.2 Ohjelmoinnin rakenne

- Qubit-allokaatio ja alustaminen

- Porttien asettelu (Hadamard, CNOT, Pauli-X/Y/Z)

- Parametrinen piiri (VQE, QAOA)

- Mittausten toisto hintatarkkuuden ja stokastisuuden tasapainottamiseksi

- Klassinen optimointi mittaustulosten perusteella

4. Tulevaisuuden näkymät

4.1 Virheenkorjaus ja fault-tolerance

IBM ennustaa ensimmäiset todistetut kvantti-etuudet (quantum advantage) omissa QPU-laitteissaan vuoteen 2026 mennessä ja tähtää vankkaan, virheenkorjausta hyödyntävään kvanttitietokoneeseen pian sen jälkeen.

4.2 Skaalautuvat QPU+GPU-järjestelmät

Nvidia ja Quantum Machines kehittävät tiivistä integraatiota, jossa kvanttiprosessorit ja klassiset supertietokoneet jakavat työkuorman erittäin nopealla väylällä. Tämä mahdollistaa reaaliaikaisen datasiirron ja aliohjelmien hajautetun ajon.

4.3 Algoritmikehitys ja ekosysteemistandardit

- Uudet kvantti-ML-algoritmit (quantum neural networks, quantum kernel methods) tuovat eksponentiaalisia nopeutuksia luokittelu- ja klusterointitehtäviin.

- Yhtenäiset rajapinnat (OpenQAOA, Qiskit Runtime) ja ekosysteemit (Quantum Developer Kit, PennyLane Hub) yleistyvät, mikä madaltaa kvanttisovellusten kehityksen kynnystä.

4.4 Hybridimallien demokratisoituminen

Kun pilvipalvelut laajenevat ja kvanttitietokoneet vakiintuvat – sekä rahoitusta että avoimen lähdekoodin kirjastoja lisätään ripeästi – yhä useampi data-tutkija ja AI-kehittäjä voi hyödyntää hybridilaskennan edut ilman syvää kvanttifysiikan erikoisosaamista.

Yhteenveto

Klassisen ja kvanttilaskennan yhdistäminen on siirtymässä kokeiluvaiheesta kaupallisiin proof-of-concept -ratkaisuihin. Nykyiset kvanttikoneet pilvessä antavat kehittäjille mahdollisuuden tutkia hybridialgoritmeja, ja vuoteen 2026 mennessä odotetaan ensimmäisiä virheenkorjattuja, laajasti skaalautuvia kvanttitietokoneita. Ohjelmointikehysten ja ekosysteemistandardien kehittyessä kvantti-AI ratkaisut tulevat entistä saavutettavimmiksi ja integroituivat sujuvasti klassisiin AI-workflown toimintoihin.

Moniagenttijärjestelmät

Moniagenttijärjestelmät perustuvat joukkoon autonomisia tekoälyagentteja, jotka kykenevät toimimaan yhteistyössä, jakamaan tietoa ja tekemään päätöksiä yhteisten tavoitteiden saavuttamiseksi. Kyseessä ei ole pelkästään teknologinen innovaatio, vaan myös sosio-tekninen järjestelmä, joka muistuttaa biologisten ekosysteemien toiminnallista monimuotoisuutta. Tällaiset järjestelmät soveltuvat esimerkiksi älykkäisiin logistiikkaverkostoihin, hajautettuun tuotantoon tai ympäristöseurantaan, missä dynaamiset olosuhteet vaativat joustavaa ja skaalautuvaa automaatiota.

Kuinka moniagenttijärjestelmiä luodaan?

Moniagenttijärjestelmät: syvällisempi katsaus ja työkalut

Moniagenttijärjestelmät koostuvat itsenäisistä tekoälyagenttien verkoista, jotka kommunikoivat, tekevät yhteistyötä ja mukautuvat muutoksiin ilman keskusohjausta. Ne tarjoavat dynaamisen, hajautetun tavan ratkaista monimutkaisia ongelmia esimerkiksi logistiikassa, tuotannossa ja ympäristöseurannassa.

Perinteiset kehykset ja alustat

Perinteiset MAS-kehykset on suunniteltu tarjoamaan agenttien hallinta-, viestintä- ja liikkuvuusominaisuudet. Ne noudattavat usein FIPA-standardia ja soveltuvat sekä tutkimukseen että tuotantoon.

- JADE (Java Agent Development Framework) tarjoaa skaalautuvan ympäristön agenttien luomiseen ja standardoidut rajapinnat viestintään.

- SPADE (Smart Python Agent Development Environment) on Python-pohjainen vaihtoehto, joka tukee agenttien välistä viestintää ja laajennettavuutta.

Simulaatioalustat akateemisessa tutkimuksessa

Simulaatioalustoilla tutkitaan agenttien välisiä vuorovaikutuksia ja ekosysteeminomaisia malleja ennen tuotantoon vientiä.

- NetLogo on helppokäyttöinen simulaatioalusta agenttipohjaiseen mallintamiseen, jota käytetään laajasti biologiassa, sosiologiassa ja ympäristötieteissä.

- Repast ja Mason ovat muita tunnettuja alustoja, mutta NetLogon intuitiivisuus tekee siitä suositun tutkimuksessa.

Avointen lähdekoodien MAS-kehykset nyt

Seuraavat työkalut tarjoavat modulaarisen tavan rakentaa hajautettuja agenttijärjestelmiä tuotantokäyttöön:

| Framework | Kieli/Alusta | Ominaisuudet | Käyttötapaukset |

|---|---|---|---|

| Tribe | Python | Modulaarisuus, helppo laajentaa agentteja | Hajautetut AI-arkkitehtuurit |

| InvictAI | JavaScript & Python | Skaalautuva agenttikoordinointi | Yritysautomaatiot, workflowt |

| LangGraph | TypeScript | Supervisor-agentit, LLM-integraatio | NLP-pohjaiset moniagenttityöt |

| Microsoft AutoGen | Python & .NET | Itseoppivat agentit, modulaariset workflow’t | Dynaamiset, skaalautuvat MAS |

Taulukon tiedot on koottu alan johtavalta konferenssialustalta ja valistuneista teknologiaraportoinneista.

LLM-pohjaiset moniagenttijärjestelmän kehykset

Uuden sukupolven agenttikehykset yhdistävät suuria kielimalleja (LLM) agenttipohjaiseen arkkitehtuuriin. Ne tarjoavat muistinhallintaa, ulkoisia integraatioita ja työkalupohjaista automaatiota.

- Agno, OpenAI Swarm, CrewAI ja Langflow tarjoavat Python-kirjastoja ja visuaalisia työkaluja agenttien rakentamiseen ja orkestrointiin.

- Vertex AI:n agenttikehykset mahdollistavat agenttien skaalautuvuutta pilvessä ja syvän integraation Google Cloudin datapalveluiden kanssa.

Yllä mainitut LLM-kehykset nopeuttavat agenttien prototyyppien kehitystä, kun perinteinen agenttisuunnittelu yhdistyy luonnollisen kielen ymmärtämiseen.

AI ilmastonmuutoksen torjunnassa

Tekoälyllä on potentiaalia olla ratkaisevassa roolissa ilmastonmuutoksen hillinnässä analysoimalla massiivisia ympäristödatoja, mallintamalla eri vaikutusmekanismeja ja ehdottamalla toimivia optimointistrategioita esimerkiksi energiankulutuksen, päästöjen ja luonnon monimuotoisuuden hallintaan. AI voi myös auttaa varhaisessa riskienhallinnassa, kuten metsäpalojen, tulvien tai sään ääri-ilmiöiden ennakoinnissa. Tämän kehityksen eettinen ulottuvuus korostuu: tekoälystä tulee osa planeetan hyvinvoinnin infrastruktuuria, ei pelkkä kaupallinen työkalu.

Taulukko tulevaisuuden trendeistä ja tekoälyn vaikutuksesta niihin

| Tulevaisuuden trendi | Kuvaus | Mahdolliset vaikutukset |

|---|---|---|

| Generatiivinen AI | Kyky luoda uutta sisältöä (tekstiä, kuvia, musiikkia) | Uudistaa sisällöntuotantoa, luovuutta ja suunnittelua |

| Reunatiedon tekoäly (Edge AI) | AI-laskenta siirtyy lähemmäs tiedon lähdettä (esim. IoT-laitteisiin) | Nopeampi päätöksenteko, parannettu tietoturva, vähäisempi pilvikustannus |

| Yhdistettävä AI (Composable AI) | Modulaaristen AI-komponenttien yhdistely monimutkaisten järjestelmien rakentamiseen | Joustavampia ja nopeampia AI-ratkaisujen kehitysprosesseja |

| Tekoälyn sääntely | Valtiot ja organisaatiot kehittävät sääntöjä eettiseen ja turvalliseen AI-käyttöön | Lisää luottamusta, vastuullisuutta ja yhdenmukaisuutta AI-kehitykseen |

| Itseohjautuva oppiminen | Mallit oppivat ilman selkeitä tunnisteita hyödyntäen self-supervised- ja unsupervised-menetelmiä | Parempi datatehokkuus, vähemmän merkittyä dataa tarvitaan |

| AI-palveluna (AI-as-a-Service) | Pilvipohjaiset, helposti integroitavat AI-API:t ja -mikropalvelut | Nopeuttaa innovointia, madaltaa kynnystä AI:n käyttöönottoon yrityksissä |

| Kvanttitietokoneiden yhdistäminen | Kvantti- ja klassisen laskennan synerginen hyödyntäminen | Mahdollistaa laskennallisesti haastavien ongelmien ratkaisemisen |

| Moniagenttijärjestelmät | Itseohjautuvien agenttien verkostot tekevät yhteistyötä ja jakavat tietoa | Parempi skaalaus, joustavat automaatioprosessit, dynaamiset ekosysteemit |

| AI ilmastonmuutoksen torjunnassa | Mallintaa kompleksisia ympäristövaikutuksia ja ehdottaa optimointistrategioita | Tehostaa hiilineutraalisuustavoitteita, parantaa luonnon monimuotoisuuden suojelua |

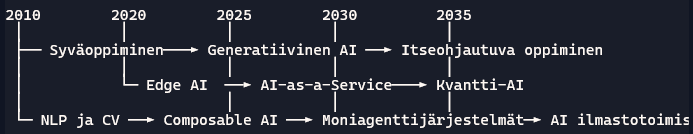

AI-trendien kehittyminen aikajanalla

Tämä aikajana havainnollistaa, miten eri trendit ovat nousemassa vuoteen 2035 mennessä hallitseviksi suuntauksiksi.

Vinkit AI-trendien hyödyntämiseen

- Seuraa alan preprintejä ja standardeja: ArXiv, IEEE, ISO/IEC AI-suositukset

- Osallistu yhteisölähtöisiin projekteihin: OpenAI Codex -kokeilut, Hugging Face -mallirepositoriot

- Kokeile hybridimalleja: yhdistä kvanttitietokoneiden simulointia klassiseen runsaasti dataa vaativaan oppimiseen

- Integroi AI-eettisyys varhaisessa vaiheessa: hyödynnä Fairlearn- ja AIF360-työkaluja sekä organisaation omia auditointikäytäntöjä

- Panosta skaalattavuuteen: rakenna MLOps-putkia Kubeflow’n, MLflow’n tai GitOps-periaatteiden avulla

AI-maailman seuraavat vuodet lupaavat merkittäviä teknologisia ja yhteiskunnallisia muutoksia. Ota ensimmäinen askel osallistumalla avoimen lähdekoodin kehitykseen, testaamalla uusia palveluita ja luomalla yhteyksiä alan ammattilaisiin. Yhdessä voimme varmistaa, että tekoäly palvelee parhaalla mahdollisella tavalla – sekä nyt että tulevaisuudessa.

Miksi tekoälyn sääntelyä tarvitaan?

- Tekoälyjärjestelmät voivat tehdä automaattisia päätöksiä, joilla on merkittäviä vaikutuksia ihmisten elämään – esimerkiksi rekrytoinnissa, lainanmyöntämisessä tai terveydenhuollossa. Ilman sääntelyä nämä järjestelmät voivat toimia epäoikeudenmukaisesti tai läpinäkymättömästi.

- Datapohjainen oppiminen voi johtaa siihen, että tekoäly vahvistaa olemassa olevia vinoumia tai syrjintää. Sääntely tarjoaa välineitä algoritmien auditointiin ja eettisten periaatteiden juurruttamiseen.

Mitä tekoälyn sääntely sisältää?

- Lainsäädäntökehykset: EU:n AI Act ja GDPR ovat esimerkkejä säädöksistä, jotka pyrkivät luomaan yhtenäisen ja oikeudenmukaisen sääntely-ympäristön. Ne asettavat vaatimuksia esimerkiksi riskienhallinnalle, läpinäkyvyydelle ja käyttäjän suostumukselle.

- Eettiset ohjeistukset: Kansainväliset ja kansalliset komiteat – kuten OECD, UNESCO ja EU:n eettinen komitea – ovat laatineet tekoälyn periaatteita, mm. ihmiskeskeisyyttä, reiluutta ja turvallisuutta korostavia normeja.

- Tekniset standardit: ISO/IEC ja IEEE kehittävät standardeja tekoälyn luotettavuuden, laadunvarmistuksen ja interoperabiliteetin varmistamiseksi.

Sääntelyn vaikutukset yhteiskuntaan?

- Luottamuksen lisääminen: Kun ihmiset kokevat, että tekoäly toimii läpinäkyvästi ja eettisesti, he ovat valmiimpia hyväksymään sen laajemman käytön arjessaan.

- Innovoinnin ohjaus: Sääntely ei tarkoita innovaatioiden rajoittamista, vaan niiden suuntaamista yhteiskunnallisesti kestävään ja turvalliseen suuntaan.

- Yhdenmukaisuus: Kansainvälisten pelisääntöjen myötä yritykset voivat kehittää globaaleja tekoälyratkaisuja ilman lainsäädännöllisiä ristiriitoja eri maiden välillä.

Tulevaisuuden haasteet?

- Sääntely ei saa jäädä kehityksen jalkoihin. Teknologian kehitys etenee niin nopeasti, että säädöksien tulee olla adaptiivisia, skaalautuvia ja tulevaisuuteen katsovia.

- Monimutkaiset AI-järjestelmät (esim. moniagenttiympäristöt tai autonomiset päätöksentekojärjestelmät) vaativat uusia lähestymistapoja valvontaan ja vastuunjakoon.